Peralihan dari eksplorasi ke operasionalisasi AI mendorong Akamai meluncurkan layanan Cloud Inference.

Menurut Jay Jenkins, CTO, Cloud Computing, Akamai Technologies, mengutip analis teknologi Jack Gold dari J.Gold & Associates, saat ini 80% investasi AI masih difokuskan pada pelatihan model, sementara hanya 20% untuk inference.

“Namun 20% inilah yang sebenarnya menghasilkan nilai dari AI, yakni implementasinya secara nyata,” tegas Jenkins.

Analis Jack Gold memproyeksikan rasio ini akan berbalik menjadi 20/80, sementara Gartner memperkirakan infrastruktur untuk AI inference akan mencapai US $1,3 triliun pada 2032

Namun, mengalihkan fokus ke inference bukan tanpa tantangan. Studi Forrester mencatat tiga hambatan utama yang dihadapi organisasi saat mengoperasionalkan AI: biaya penyimpanan dan pemrosesan (60%), isu latensi (56%), serta kesulitan dalam meningkatkan skalabilitas aplikasi (45%).

Selain itu, 55% pemimpin TI percaya komputasi terdistribusi akan mengurangi risiko bisnis, 54% menganggap ini menahan laju biaya runaway, dan 49% meyakini waktu untuk mendapatkan nilai AI (time‑to‑value) akan semakin singkat.

Untuk mengatasi tantangan operasional AI tersebut, Akamai menerapkan edge‑first architecture, memanfaatkan 4.100 titik kehadiran edge miliknya yang tersebar di seluruh dunia untuk menjalankan inference sedekat mungkin dengan pengguna.

Jay Jenkins mengungkapkan hasil pengujian internal inference image generation menggunakan GPU RTX 4000 AIDA di edge. Proses inference ini bisa dilakukan 2,5× lebih cepat dan 86% lebih murah per permintaan, dibandingkan GPU milik hyperscaler besar. Persentase tersebut, menurut Jay, belum termasuk biaya egress. “Dengan egress, perusahaan akan menghemat lebih banyak lagi,” imbuhnya.

Akamai mengenakan biaya egress data sebesar US $0,005/GB, atau sekitar setengah sen per gigabyte, dan skema sewa VM/GPU per jam, sehingga terjangkau bagi startup maupun UKM.

Jay Jenkins menegaskan struktur harga ini dirancang agar startup dan UKM dapat mengestimasi pengeluaran mereka secara fleksibel—dari jam penggunaan GPU, volume egress, hingga opsi penyimpanan—tanpa terkejut oleh biaya tak terduga.

Selain itu, Akamai menjamin portabilitas model dengan mengadopsi teknologi open source seperti Kubernetes (Kubeflow, KServe), dan WebAssembly (Spin). Pendekatan ini memudahkan perusahaan untuk memindahkan model antarcloud provider, sekaligus menjaga agar tidak terjebak dalam satu ekosistem vendor.

Demi keamanan inference AI, Akamai menghadirkan firewall for AI dan menganjurkan pendekatan zero‑trust dengan micro‑segmentation, sehingga inferensi di edge tetap tahan menghadapi serangan siber canggih.

Early adopters layanan ini mencakup ad tech, gaming, media, retail, dan SaaS, yang memanfaatkan latency rendah dan biaya egress minim untuk use‑case seperti real‑time bidding, rekomendasi hyper‑lokal, streaming tinggi, dan anti‑cheat.

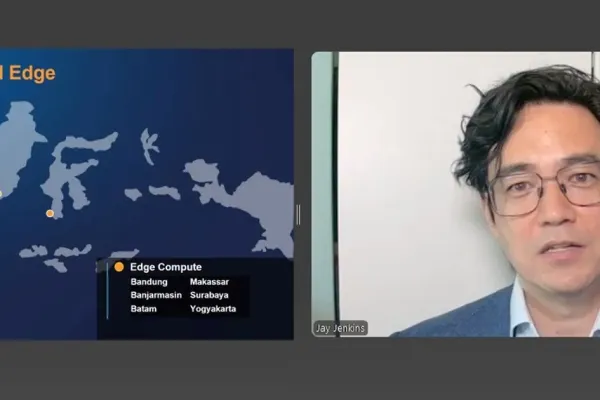

Di Indonesia, yang memiliki adopsi AI tertinggi di Asia Tenggara dengan persentase 24,6% (diikuti Thailand 17,1%, Singapura 9,9%, Malaysia 8,1% menurut IDC), Akamai menempatkan satu data center utama di Jakarta plus enam lokasi edge computing lainnya. Dengan jaringan ini, menurut Jay Jenkins, Akamai mampu melayani 280 juta penduduk di 18.000 pulau, menjaga agar data pengguna tetap diproses dalam wilayah hukum setempat, sekaligus membantu perusahaan mematuhi regulasi kedaulatan data .